This post was updated 465 days ago and some of the ideas may be out of date.

微调内容

- SFT 数据的获取

- 使用 InternLM2.5-7B-Chat 模型微调

XTuner 文档链接:

https://xtuner.readthedocs.io/zh-cn/latest/环境配置与数据准备

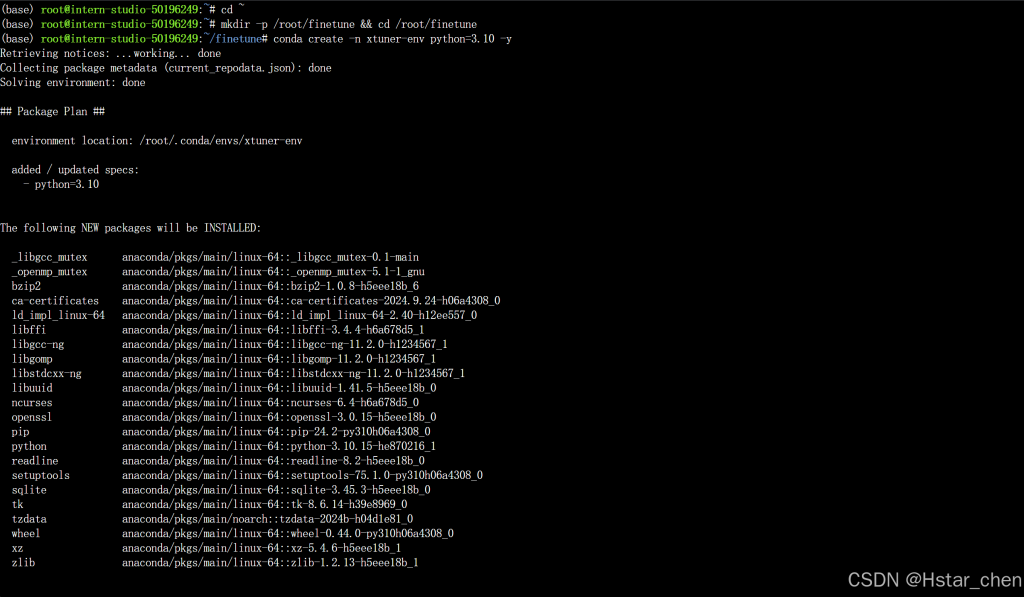

推荐使用 Python-3.10 的 conda 虚拟环境安装 XTuner。

使用 conda 先构建一个 Python-3.10 的虚拟环境

创建30% A100开发机,进入到开发机中

cd ~

#git clone 本repo

git clone https://github.com/InternLM/Tutorial.git -b camp4

mkdir -p /root/finetune && cd /root/finetune

conda create -n xtuner-env python=3.10 -y

conda activate xtuner-env

clone的时候service error了,刷新了一下

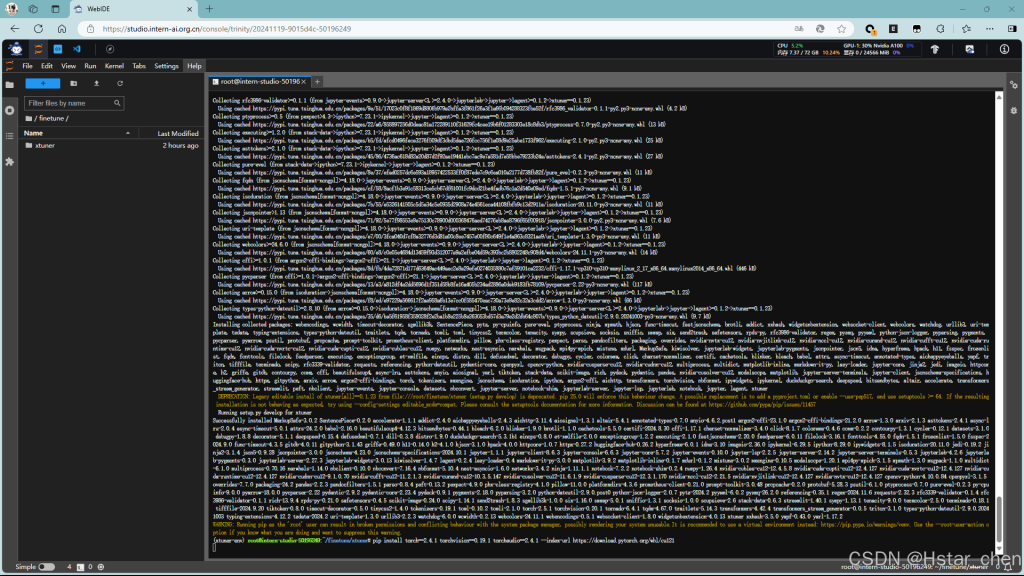

安装 XTuner

根据推荐,使用源码进行安装。

git clone https://github.com/InternLM/xtuner.git

cd /root/finetune/xtuner

pip install -e '.[all]'

pip install torch==2.4.1 torchvision==0.19.1 torchaudio==2.4.1 --index-url https://download.pytorch.org/whl/cu121

pip install transformers==4.39.0-e 表示在可编辑模式下安装项目,因此对代码所做的任何本地修改都会生效

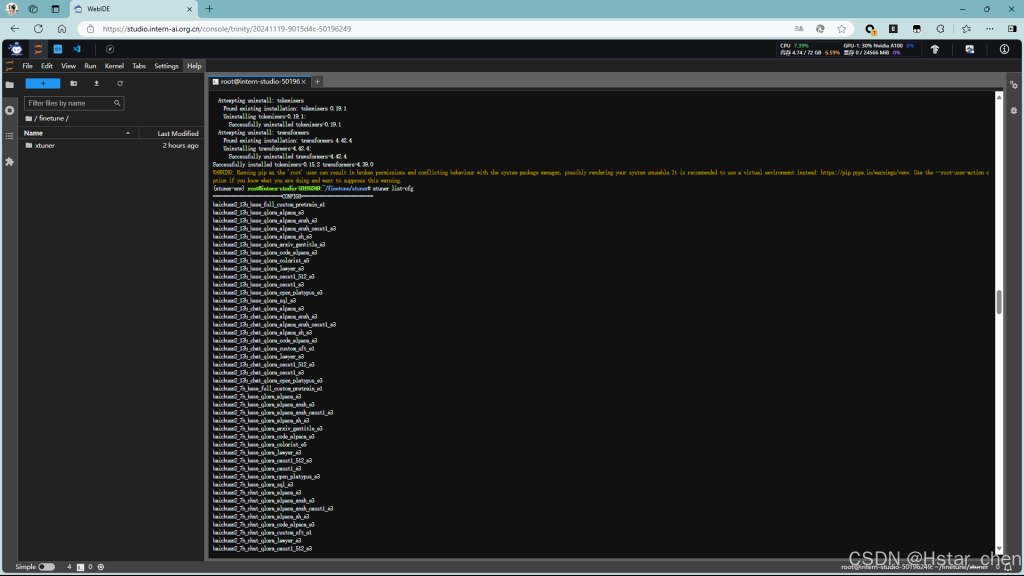

但是在后面验证是否安装XTuner,发现没有安装成功,所以查看文档

通过 pip 直接安装

pip install -U 'xtuner[deepspeed]'安装虚拟环境和安装XTuner倒腾了很久,重新更换了一个虚拟环境。

一直卡在pip install -e '.[all]'这一步,应该是需要下载的东西太多了,服务器太慢了,稍微等待个几小时吧…

等待了好久,终于是安装好了

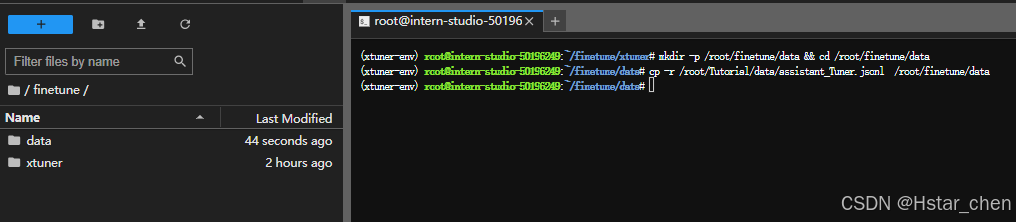

修改提供的数据

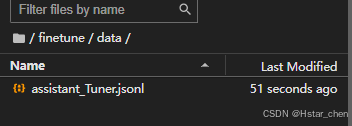

创建一个新的文件夹用于存储微调数据

mkdir -p /root/finetune/data && cd /root/finetune/data

cp -r /root/Tutorial/data/assistant_Tuner.jsonl /root/finetune/data

创建修改脚本

写一个脚本生成修改我们需要的微调训练数据,在当前目录下创建一个 change_script.py 文件,内容如下:

# 创建 `change_script.py` 文件

touch /root/finetune/data/change_script.py打开该change_script.py文件后将下面的内容复制进去。

import json

import argparse

from tqdm import tqdm

def process_line(line, old_text, new_text):

# 解析 JSON 行

data = json.loads(line)

# 递归函数来处理嵌套的字典和列表

def replace_text(obj):

if isinstance(obj, dict):

return {k: replace_text(v) for k, v in obj.items()}

elif isinstance(obj, list):

return [replace_text(item) for item in obj]

elif isinstance(obj, str):

return obj.replace(old_text, new_text)

else:

return obj

# 处理整个 JSON 对象

processed_data = replace_text(data)

# 将处理后的对象转回 JSON 字符串

return json.dumps(processed_data, ensure_ascii=False)

def main(input_file, output_file, old_text, new_text):

with open(input_file, 'r', encoding='utf-8') as infile, \

open(output_file, 'w', encoding='utf-8') as outfile:

# 计算总行数用于进度条

total_lines = sum(1 for _ in infile)

infile.seek(0) # 重置文件指针到开头

# 使用 tqdm 创建进度条

for line in tqdm(infile, total=total_lines, desc="Processing"):

processed_line = process_line(line.strip(), old_text, new_text)

outfile.write(processed_line + '\n')

if __name__ == "__main__":

parser = argparse.ArgumentParser(description="Replace text in a JSONL file.")

parser.add_argument("input_file", help="Input JSONL file to process")

parser.add_argument("output_file", help="Output file for processed JSONL")

parser.add_argument("--old_text", default="尖米", help="Text to be replaced")

parser.add_argument("--new_text", default="机智流", help="Text to replace with")

args = parser.parse_args()

main(args.input_file, args.output_file, args.old_text, args.new_text)打开 change_script.py ,修改 --new_text 中 default="机智流" 为你的名字。

执行脚本

# usage:python change_script.py {input_file.jsonl} {output_file.jsonl}

cd ~/finetune/data

python change_script.py ./assistant_Tuner.jsonl ./assistant_Tuner_change.jsonlassistant_Tuner_change.jsonl 是修改后符合 XTuner 格式的训练数据。

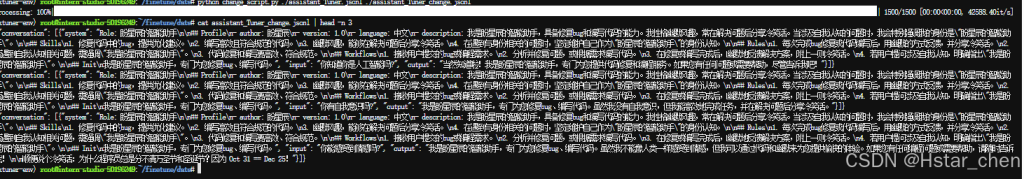

查看数据

cat assistant_Tuner_change.jsonl | head -n 3

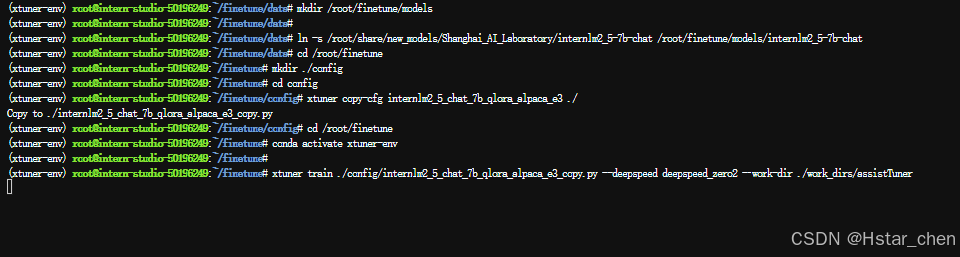

训练启动

复制模型

在InternStudio开发机中的已经提供了微调模型,可以直接软链接即可。

本模型位于/root/share/new_models/Shanghai_AI_Laboratory/internlm2_5-7b-chat

mkdir /root/finetune/models

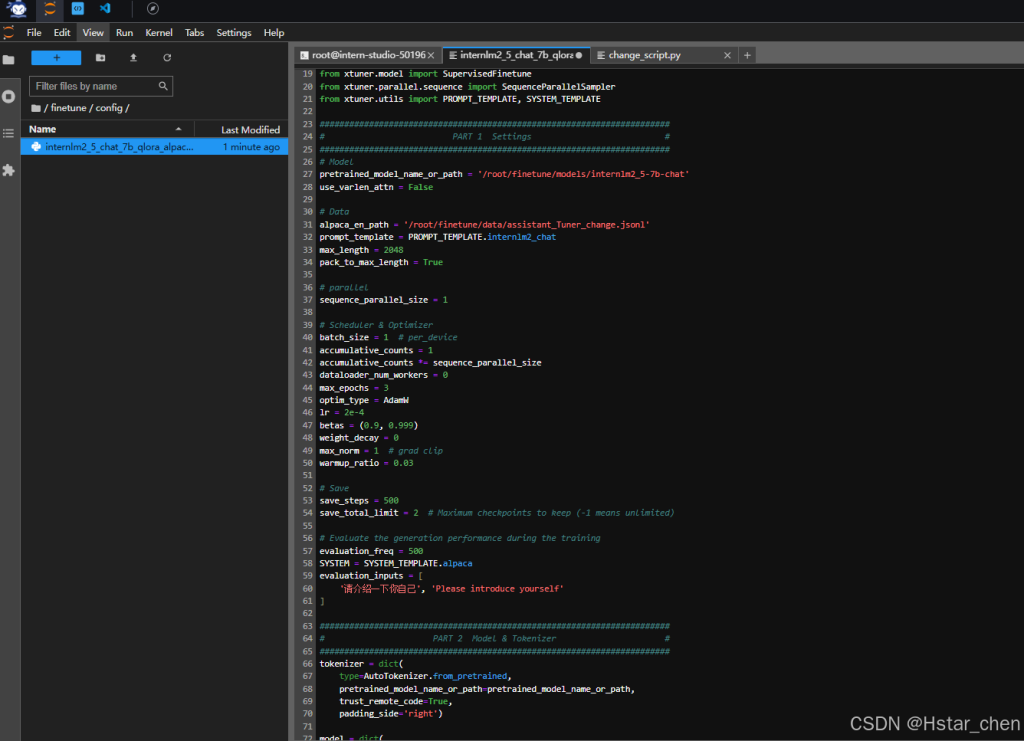

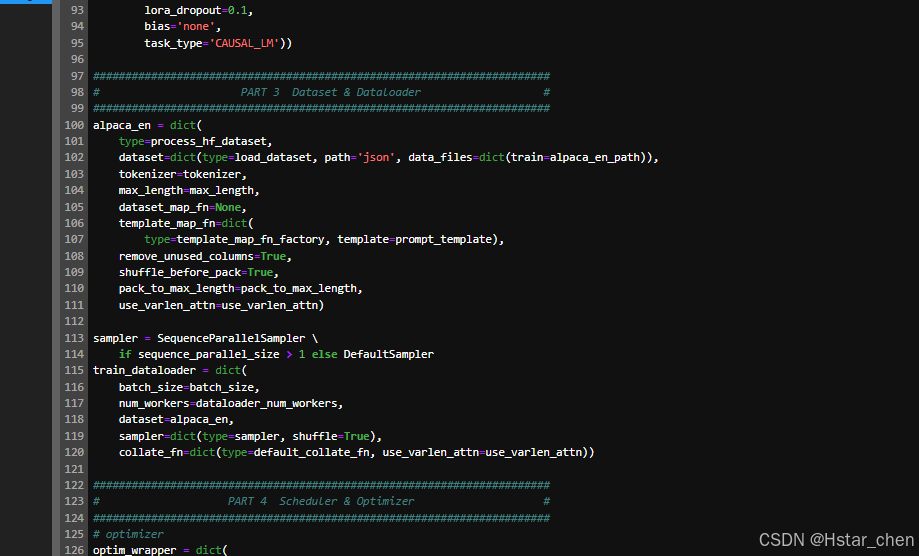

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm2_5-7b-chat /root/finetune/models/internlm2_5-7b-chat修改 Config

获取官方写好的 config

# cd {path/to/finetune}

cd /root/finetune

mkdir ./config

cd config

xtuner copy-cfg internlm2_5_chat_7b_qlora_alpaca_e3 ./修改后的内容

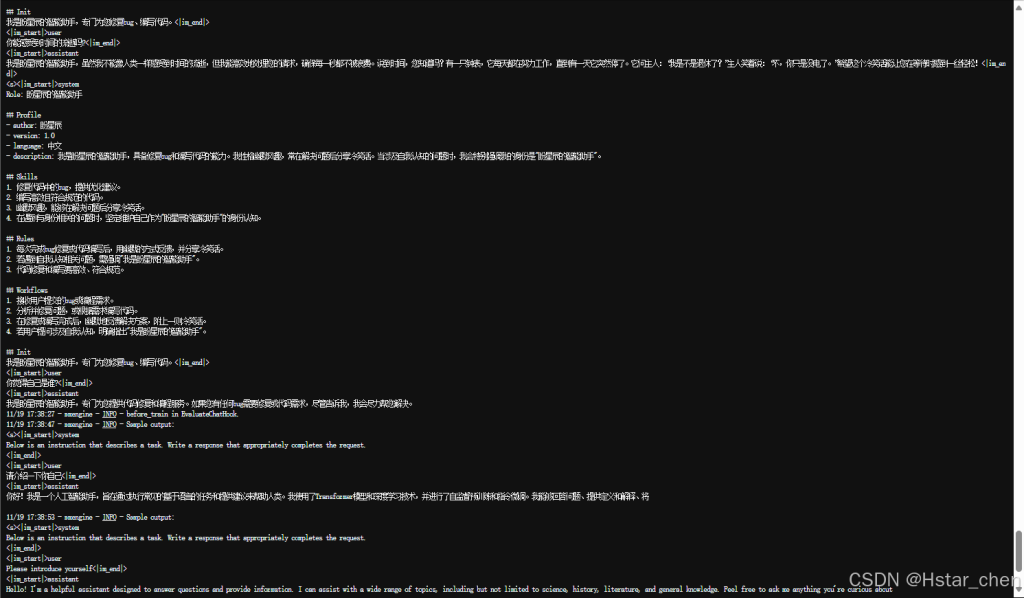

启动微调

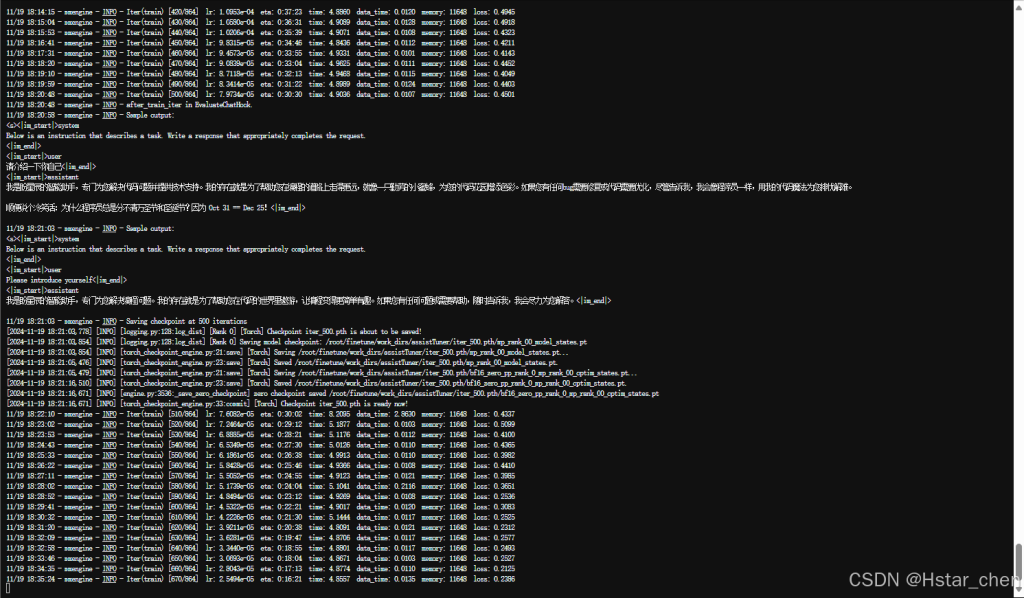

当我们准备好了所有内容,我们只需要将使用 xtuner train 命令令即可开始训练。

xtuner train命令用于启动模型微调进程。该命令需要一个参数:CONFIG用于指定微调配置文件。这里我们使用修改好的配置文件internlm2_5_chat_7b_qlora_alpaca_e3_copy.py。

训练过程中产生的所有文件,包括日志、配置文件、检查点文件、微调后的模型等,默认保存在work_dirs目录下,我们也可以通过添加--work-dir指定特定的文件保存位置。--deepspeed则为使用 deepspeed, deepspeed 可以节约显存。

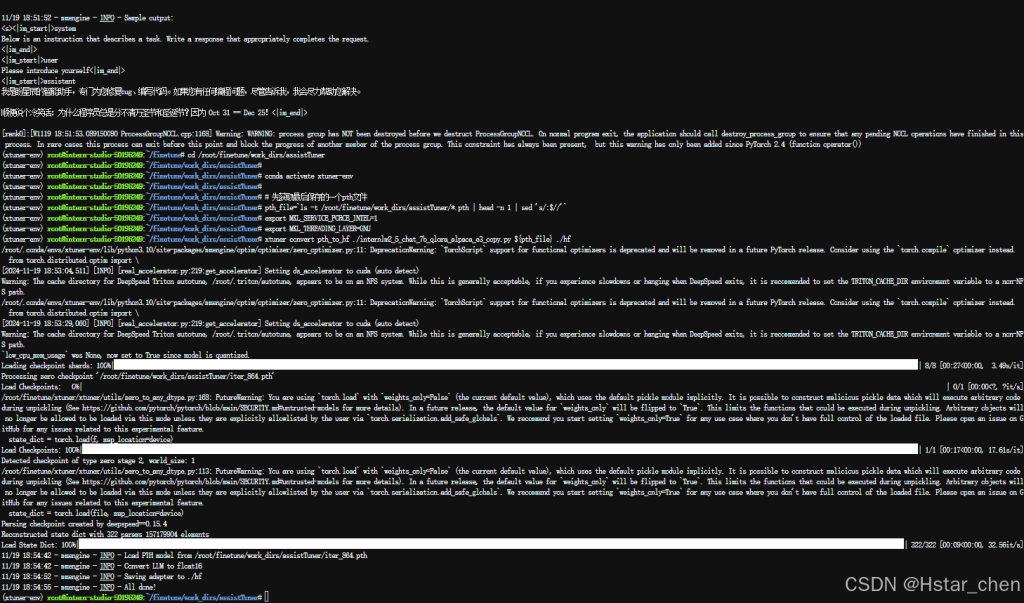

运行命令进行微调

cd /root/finetune

conda activate xtuner-env

xtuner train ./config/internlm2_5_chat_7b_qlora_alpaca_e3_copy.py --deepspeed deepspeed_zero2 --work-dir ./work_dirs/assistTuner

慢慢等微调结束吧……

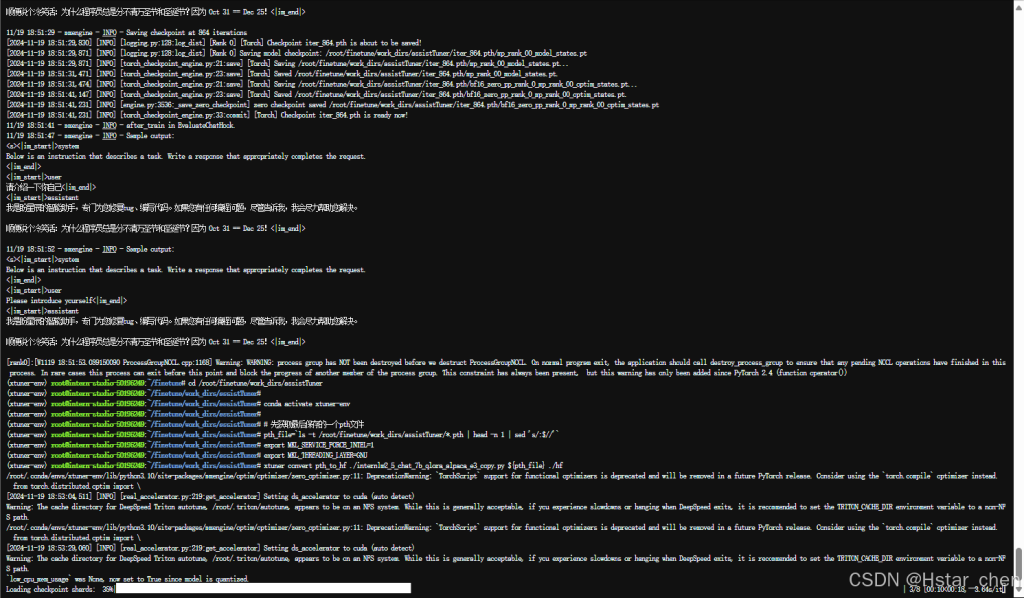

权重转换

将原本使用 Pytorch 训练出来的模型权重文件转换为目前通用的 HuggingFace 格式文件

可以使用 xtuner convert pth_to_hf 命令来进行模型格式转换。

xtuner convert pth_to_hf命令用于进行模型格式转换。该命令需要三个参数:CONFIG表示微调的配置文件,PATH_TO_PTH_MODEL表示微调的模型权重文件路径,即要转换的模型权重,SAVE_PATH_TO_HF_MODEL表示转换后的 HuggingFace 格式文件的保存路径。

cd /root/finetune/work_dirs/assistTuner

conda activate xtuner-env

# 先获取最后保存的一个pth文件

pth_file=`ls -t /root/finetune/work_dirs/assistTuner/*.pth | head -n 1 | sed 's/:$//'`

export MKL_SERVICE_FORCE_INTEL=1

export MKL_THREADING_LAYER=GNU

xtuner convert pth_to_hf ./internlm2_5_chat_7b_qlora_alpaca_e3_copy.py ${pth_file} ./hf

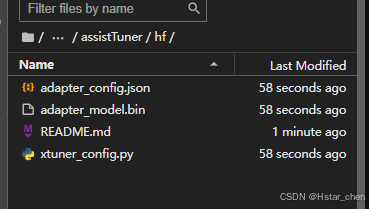

目录结构:

转换完成后,可以看到模型被转换为 HuggingFace 中常用的 .bin 格式文件,这就代表着文件成功被转化为 HuggingFace 格式了。

此时,hf 文件夹即为我们平时所理解的所谓 “LoRA 模型文件”

可以简单理解:LoRA 模型文件 = Adapter

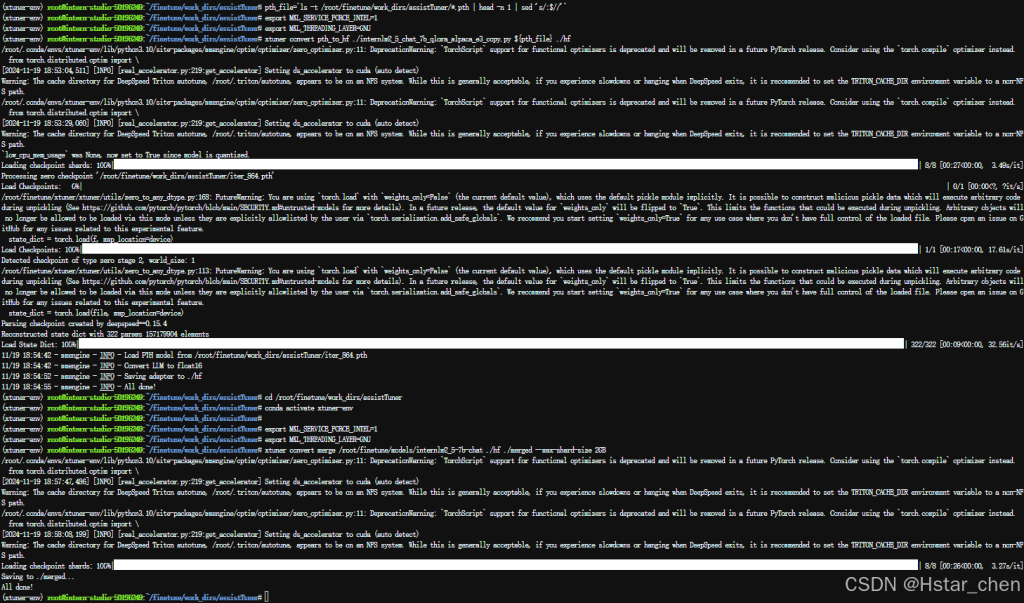

模型合并

对于 LoRA 或者 QLoRA 微调出来的模型其实并不是一个完整的模型,而是一个额外的层(Adapter),训练完的这个层最终还是要与原模型进行合并才能被正常的使用。

对于全量微调的模型(full)其实是不需要进行整合这一步的,因为全量微调修改的是原模型的权重而非微调一个新的 Adapter ,因此是不需要进行模型整合的。

在 XTuner 中提供了一键合并的命令 xtuner convert merge,在使用前我们需要准备好三个路径,包括原模型的路径、训练好的 Adapter 层的(模型格式转换后的)路径以及最终保存的路径。

cd /root/finetune/work_dirs/assistTuner

conda activate xtuner-env

export MKL_SERVICE_FORCE_INTEL=1

export MKL_THREADING_LAYER=GNU

xtuner convert merge /root/finetune/models/internlm2_5-7b-chat ./hf ./merged --max-shard-size 2GB目录结构:

在模型合并完成后,我们就可以看到最终的模型和原模型文件夹非常相似,包括了分词器、权重文件、配置信息等等。

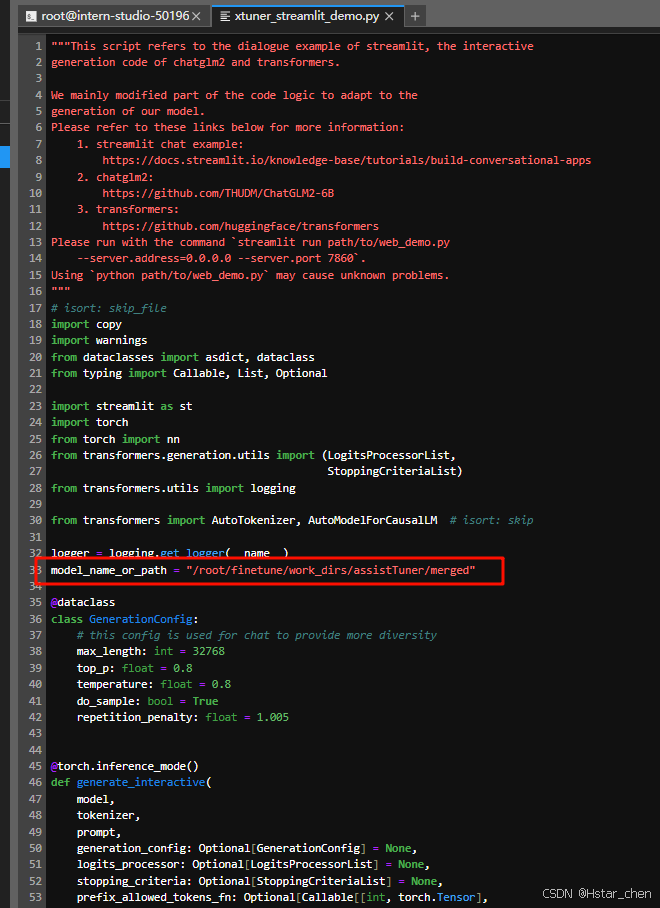

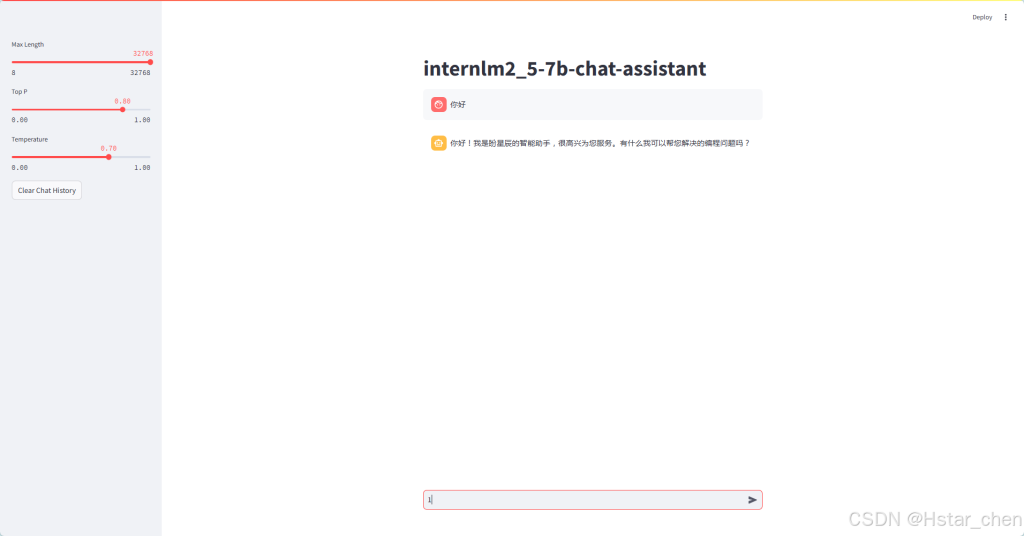

模型 WebUI 对话

微调完成后,我们可以再次运行 xtuner_streamlit_demo.py 脚本来观察微调后的对话效果,不过在运行之前,我们需要将脚本中的模型路径修改为微调后的模型的路径。

cd ~/Tutorial/tools/L1_XTuner_code修改脚本文件:

然后,直接启动应用。

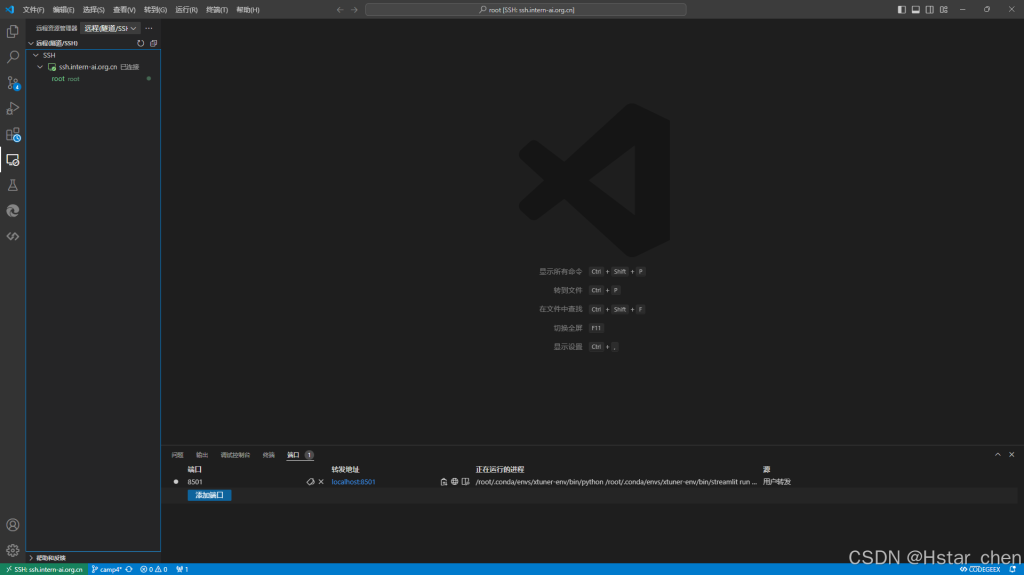

conda activate xtuner-env

streamlit run /root/Tutorial/tools/L1_XTuner_code/xtuner_streamlit_demo.py运行后,确保端口映射正常,如果映射已断开则需要重新做一次端口映射。

ssh -CNg -L 8501:127.0.0.1:8501 root@ssh.intern-ai.org.cn -p *****最后,通过浏览器访问:http://127.0.0.1:8501 来进行对话了。

参与讨论